Wie im echten Leben scheint es auch in der neuen virtuellen Realität von Facebook-Mutterkonzern Meta ganz reale Probleme zu geben.

Das Netzwerk „Horizon“ möchte seine User nun mit virtuellen Schutzblasen gegen Probleme, wie sexuelle Belästigung schützen.

Was ist Horizon? Es klingt nach Science-Fiction, ist aber bereits ein Bestandteil der Gegenwart. Die Möglichkeit, sich als virtueller Charakter, sogenannter Avatar, in einer erlebbaren Computerwelt zu bewegen. Dort kann man in seiner digitalen Persona Menschen treffen, Spiele spielen und beinahe in einer Art virtuellen Parallelwelt leben. Hierzu wurde von der Facebook-Mutter Meta das Virtual-Reality-Netzwerk „Horizon“ entwickelt. Das Ziel von Meta sei es dabei, die Grenzen zwischen physischer und digitaler Welt in einem virtuellen Universum verschwimmen zu lassen. Seit Dezember ist Horizon in den USA und Kanada bereits für User verfügbar.

Erste Maßnahmen gegen Belästigung haben nicht ausgereicht

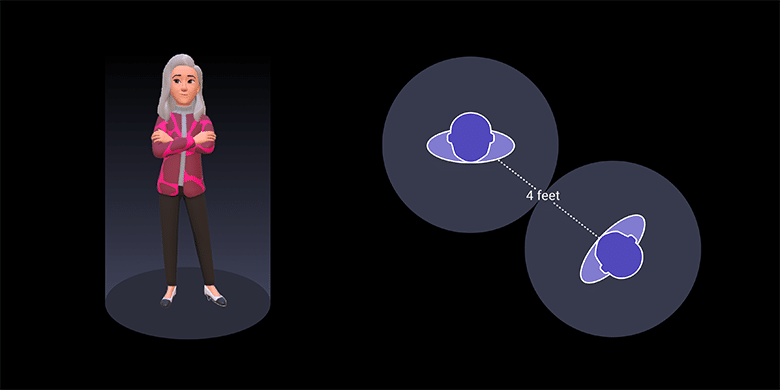

Wie sich nun zeigt, sind allerdings auch in einer digitalen Realität die Problematiken ähnlich, wie im echten Leben und es gibt immer mehr Beschwerden über Belästigungen der Nutzerinnen und Nutzer. Eine Userin berichtet, sie sei innerhalb von 60 Sekunden nach ihrem Beitritt „verbal und sexuell belästigt“ worden. Dagegen wird Horizon nun eine Mindestabstandsregel in Form einer virtuellen Schutzblase einrichten. Diese verhindert, dass sich Nutzerinnen und Nutzer einander uneingeschränkt nähern können, wenn dies nicht gewünscht ist. Wie Horizon-Vizepräsident Vivek Sharma erklärt, stoppe das System die Vorwärtsbewegung eines herannahenden Avatars, sobald dieser die Grenze einer Schutzblase erreicht. Eine bereits eingerichtete Anti-Belästigungs-Funktion habe scheinbar nicht ausgereicht. Diese lässt die Hände eines Avatars verschwinden, sollte dieser beabsichtigen, eine andere virtuelle Figur unangemessen „anzufassen“.

Zukünftig soll Schutzraum individuell definiert werden können

Die Größe der Schutzblase solle zunächst vier Fuß, also etwas mehr als einen Meter betragen. Im Laufe der Zeit solle es hier laut Meta jedoch Verbesserungen und Anpassungen geben, je nachdem, wie sich die Maßnahme auf das Erleben der Nutzerinnen und Nutzer auswirke. Die Abstandsregelung solle erstmal standartmäßig bei jedem Avatar aktiviert sein, um so gewisse Verhaltensnormen im virtuellen Raum zu etablieren, berichtet der Tech-Konzern. Perspektivisch soll es aber möglich sein, die Größe der persönlichen Grenze anzupassen und weitere Einstellungen vorzunehmen.

Quellen: Introducing a Personal Boundary for Horizon Worlds and Venues

Hinweise: 1) Dieser Inhalt gibt den Stand der Dinge wieder, der zum Zeitpunkt der Veröffentlichung aktuell war. Die Wiedergabe einzelner Bilder, Screenshots, Einbettungen oder Videosequenzen dient zur Auseinandersetzung der Sache mit dem Thema.

2) Einzelne Beiträge entstanden durch den Einsatz von maschineller Hilfe und wurde vor der Publikation gewissenhaft von der Mimikama-Redaktion kontrolliert. (Begründung)