Facebook go home, you´re drunk

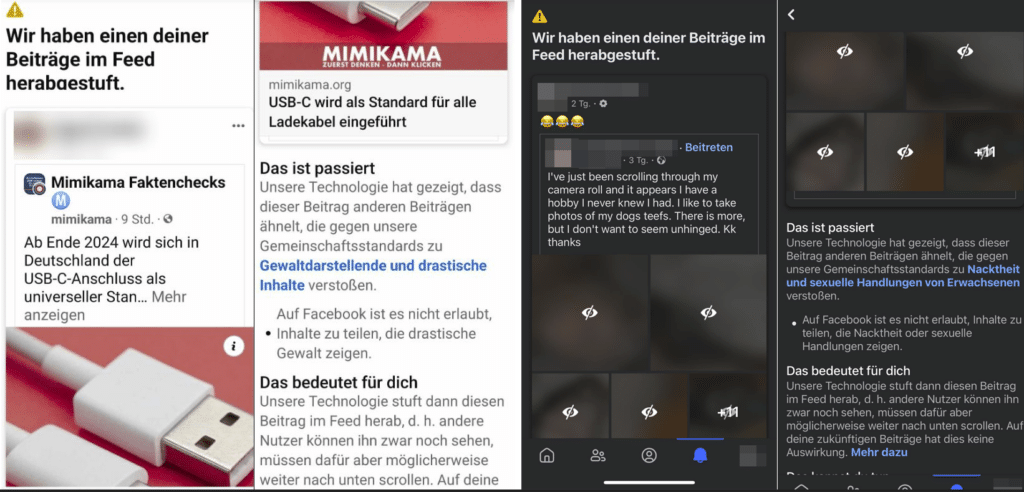

In den letzten Tagen hat Facebook seine Nutzer vermehrt mit Benachrichtigungen darüber informiert, dass bestimmte Beiträge in ihrem Newsfeed herabgestuft wurden, weil sie angeblich gegen die Gemeinschaftsstandards verstoßen. Diese automatisierte Maßnahme, die von der Technologie des sozialen Netzwerks durchgeführt wird, scheint jedoch erhebliche Fehlurteile zu produzieren. So wurden beispielsweise harmlose Bilder von Hundeschnauzen fälschlicherweise als Nacktheit und sexuelle Handlungen eingestuft, während USB-Anschlüsse als Gewaltdarstellungen und drastische Inhalte fehlinterpretiert wurden.

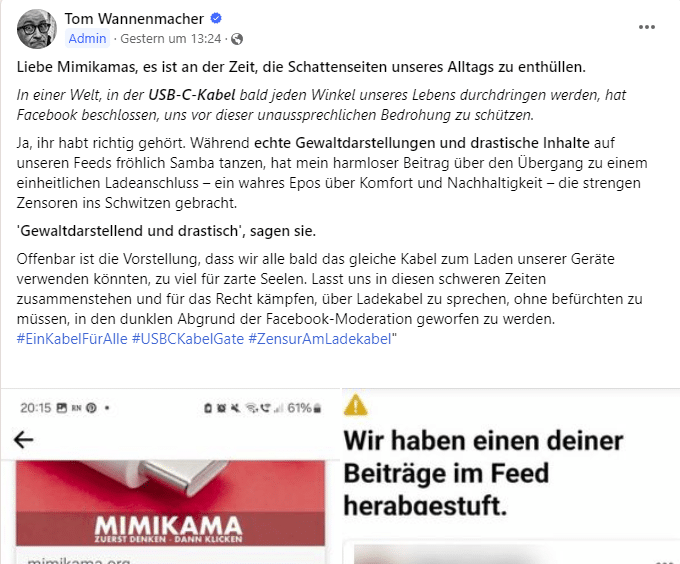

Bei dem ersten Bild handelt es sich um ein Artikelbild zum Thema „USB-C wird als Standard für alle Ladekabel eingeführt“. In unserer Facebook-Gruppe haben wir zu Facebooks „interessanter“ Entscheidung einen Beitrag gepostet.

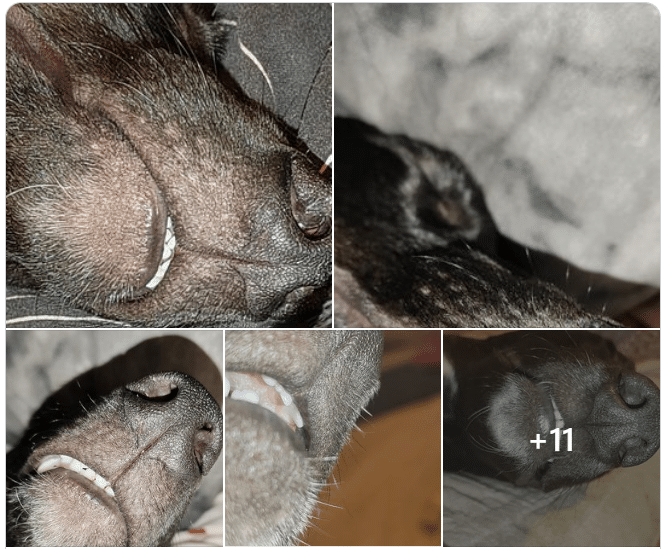

Das zweite Posting betraf Hundeschnauzen.

Wir können uns in diesen Fällen beim besten Willen nicht erklären, mit welchen Bildern oder Inhalten die Facebook-KI gelernt hat, USB-Kabel und Hundeschnauzen als gewaltdarstellend oder sexuell zu erkennen, und hoffen sehr, dass es sich um einen aktuell auftretenden Bug handelt. Möglicherweise finden zur Zeit Justierungen an Facebooks eingesetzter Technologie statt, was zu derart wundersamen Fehlern führt?

Diese Vorfälle werfen allerdings dringende Fragen nach der Zuverlässigkeit und Effizienz der verwendeten Algorithmen auf. Wenn Nutzer Einspruch erheben, werden die betreffenden Beiträge einer erneuten Prüfung unterzogen und – wenig überraschend – in den meisten Fällen nicht mehr als problematisch eingestuft. Dennoch hinterlässt dieses Vorgehen einen bitteren Nachgeschmack: Wie kann es sein, dass eine Plattform, die für ihre fortschrittliche Technologie bekannt ist, derart gravierende Fehler macht?

Grenzen von Facebooks künstlicher Intelligenz

Die aktuellen Fehlalarme offenbaren die begrenzte Fähigkeit künstlicher Intelligenz (KI), komplexe menschliche Inhalte korrekt zu interpretieren. Während die Absicht, unangemessene Inhalte zu filtern, lobenswert ist, führt die offensichtliche Unzulänglichkeit der Algorithmen zu Frustration und Verwirrung bei den Nutzern. Es entsteht der Eindruck, dass die Technologie in einigen Fällen „übermotiviert“ ist, was zu ungerechtfertigten Einschränkungen führt.

Die Herausforderung der inhaltlichen Moderation

Das Problem beschränkt sich jedoch nicht nur auf fehlerhafte Beschränkungen. Die Plattform steht auch in der Kritik, weil sie oft nicht in der Lage ist, wirklich problematische Inhalte wie Fakes, Betrug oder explizite Darstellungen effektiv zu erkennen und zu entfernen. Diese scheinbare Inkonsistenz bei der Moderation von Inhalten wirft Fragen nach den Prioritäten und Methoden von Facebook auf. Wie kann es sein, dass offensichtliche Verstöße gegen die Nutzungsbedingungen ungeahndet bleiben, während harmlose Inhalte fälschlicherweise sanktioniert werden?

Technik oder menschliches Versagen?

Die aktuellen Ereignisse unterstreichen die Notwendigkeit eines ausgewogeneren Ansatzes für die Moderation von Inhalten, der sowohl technologische als auch menschliche Elemente umfasst. Algorithmen müssen ständig verbessert und an die komplexen Nuancen menschlicher Kommunikation angepasst werden. Gleichzeitig muss sichergestellt werden, dass menschliche Moderatoren als Sicherheitsnetz dienen, um die Grenzen der Technologie auszugleichen.

Fragen und Antworten zu den technischen Problemen von Facebook:

Frage 1: Was sind die Hauptprobleme der automatisierten Inhaltsmoderation von Facebook?

Antwort 1: Die Hauptprobleme sind Fehleinschätzungen durch Algorithmen, die harmlose Inhalte als Verstöße markieren, und das Versäumnis, tatsächlich problematische Inhalte effektiv zu identifizieren und zu entfernen.

Frage 2: Wie wirken sich diese Probleme auf das Nutzererlebnis aus?

Antwort 2: Sie führen zu Verwirrung, Frustration und einem Vertrauensverlust in die Plattform, da die Nutzer ungerechtfertigten Einschränkungen ausgesetzt sind und problematische Inhalte weiterhin auf der Plattform verbleiben.

Frage 3: Was ist die Ursache für diese Fehlbewertungen?

Antwort 3: Die Ursache liegt in den begrenzten Fähigkeiten der künstlichen Intelligenz, die komplexe menschliche Inhalte nicht immer richtig interpretieren kann.

Frage 4: Was könnte Facebook tun, um diese Probleme zu lösen?

Antwort 4: Facebook könnte seine Algorithmen kontinuierlich verbessern und sicherstellen, dass menschliche Überprüfer als Sicherheitsnetz fungieren, um die Grenzen der Technologie auszugleichen.

Frage 5: Warum ist ein ausgewogener Ansatz bei der Moderation von Inhalten wichtig?

Antwort 5: Ein ausgewogener Ansatz ist wichtig, um sicherzustellen, dass die Plattform ein sicherer und einladender Ort für alle Nutzer bleibt, ohne ungerechtfertigte Einschränkungen oder das Übersehen problematischer Inhalte.

Fazit

Die jüngsten Pannen bei der Moderation von Inhalten auf Facebook unterstreichen die Notwendigkeit einer überarbeiteten Strategie, die sowohl die Präzision der technologischen Lösungen erhöht als auch menschliches Urteilsvermögen einbezieht. Ein solcher Ansatz könnte dazu beitragen, das Vertrauen der Nutzer wiederherzustellen und die Plattform als sicheren Raum für Austausch und Interaktion zu erhalten. Es bleibt zu hoffen, dass Facebook diese Vorfälle zum Anlass nimmt, seine Praktiken zu überdenken und zu verbessern.

Wir laden Sie ein, sich für den Mimikama-Newsletter zu registrieren und unsere Online-Vorträge und Workshops zu besuchen, um sich weiter über digitale Sicherheit und den kritischen Umgang mit Online-Inhalten zu informieren.

Das könnte Sie auch interessieren:

Sehnsucht nach Einfachheit: Social Media neu denken

Meta im Visier: Illegale Medikamente und Netzpolitik

KI-Zukunft: Fortschritt oder Apokalypse?

Unsere virtuelle Faktencheck-Bewertungsskala: Bei der Überprüfung von Fakten, in der Kategorie der „Faktenchecks„, nutzen wir eine klare Bewertungsskala, um die Zuverlässigkeit der Informationen zu klassifizieren. Hier eine kurze Erläuterung unserer Kategorien:

- Rot (Falsch/Irreführend): Markiert Informationen, die definitiv falsch oder irreführend sind.

- Gelb (Vorsicht/Unbewiesen/Fehlender Kontext/Satire): Für Inhalte, deren Wahrheitsgehalt unklar ist, die mehr Kontext benötigen oder satirisch sind.

- Grün (Wahr): Zeigt an, dass Informationen sorgfältig geprüft und als wahr bestätigt wurden.

Unterstütze jetzt Mimikama – Für Wahrheit und Demokratie! Gründlicher Recherchen und das Bekämpfen von Falschinformationen sind heute wichtiger für unsere Demokratie als jemals zuvor. Unsere Inhalte sind frei zugänglich, weil jeder das Recht auf verlässliche Informationen hat. Unterstützen Sie Mimikama

Mehr von Mimikama

Hinweise: 1) Dieser Inhalt gibt den Stand der Dinge wieder, der zum Zeitpunkt der Veröffentlichung aktuell war. Die Wiedergabe einzelner Bilder, Screenshots, Einbettungen oder Videosequenzen dient zur Auseinandersetzung der Sache mit dem Thema.

2) Einzelne Beiträge entstanden durch den Einsatz von maschineller Hilfe und wurde vor der Publikation gewissenhaft von der Mimikama-Redaktion kontrolliert. (Begründung)