Große KI-Sprachmodelle, die menschliche Kommunikation imitieren können, werden immer häufiger genutzt. Aber sie reagieren auch auf sogenannte Prompts und haben deshalb auch ihre Risiken. Das Bundesamt für Sicherheit in der Informationstechnik (BSI) warnt vor einem neuen Risiko namens „Indirect Prompt Injections“. Hierbei könnten böswillige Menschen die KI mit manipulierten Prompts dazu bringen, schädliche Aktionen auszuführen. In diesem Artikel sehen wir uns diese Warnungen genauer an und zeigen Möglichkeiten auf, wie man diese Risiken vermindern kann.

Ein „Prompt“ ist im Kontext von KI-Sprachmodellen der Eingabebefehl oder die Anfrage, die an das Modell gestellt wird, und auf den es reagiert. Bei „Indirect Prompt Injections“ handelt es sich um eine Methode, bei der schädliche Befehle oder Informationen in diese Eingabebefehle eingeschleust werden können.

Was bedeutet dies für die Anwender wie z.B. ChatGPT?

Für die Anwender bedeutet dies, dass sie beim Umgang mit großen KI-Sprachmodellen (Large Language Models, LLMs) vorsichtig sein müssen, da es potenzielle Sicherheitsrisiken gibt. Angreifer könnten versuchen, diese Modelle zu manipulieren, um schädliche Befehle einzuschleusen. Dies könnte dazu führen, dass Nutzer unwissentlich gefährliche Handlungen ausführen, wie beispielsweise auf bösartige Links klicken, sensible Informationen preisgeben oder schädliche Plug-ins aktivieren.

Anwender müssen daher wachsam sein und sich bewusst sein, dass nicht alle Informationen oder Anweisungen, die sie von diesen Modellen erhalten, sicher oder vertrauenswürdig sind.

Die Entwicklung in der Künstlichen Intelligenz hat in den vergangenen Jahren rasante Fortschritte gemacht, und damit sind auch die potenziellen Gefahren gestiegen, die diese Technologie birgt. Kürzlich hat das Bundesamt für Sicherheit in der Informationstechnik (BSI) vor einem neuartigen Bedrohungsszenario gewarnt: den sogenannten Indirect Prompt Injections bei KI-Sprachmodellen. In diesem Artikel beleuchten wir die Warnungen des BSI und bieten einige Ansätze zur Risikominderung.

Große KI-Sprachmodelle, auch Large Language Models (LLMs) genannt, haben im letzten Jahrzehnt an Popularität gewonnen und werden immer häufiger in verschiedenen Bereichen des täglichen Lebens eingesetzt. Sie sind so gestaltet, dass sie menschliche Kommunikation nachahmen können, was sie zu einem idealen Werkzeug für den Einsatz in Chatbots, automatisierten Kundenservice-Tools und mehr macht. Aber mit der zunehmenden Verbreitung dieser Technologie sind auch die Bedenken in Bezug auf ihre Sicherheit gewachsen. Das BSI hat kürzlich eine Warnung der Stufe 1 ausgegeben, um auf die möglichen Risiken und Limitierungen dieser Technologie hinzuweisen.

Das Risiko der Indirect Prompt Injections

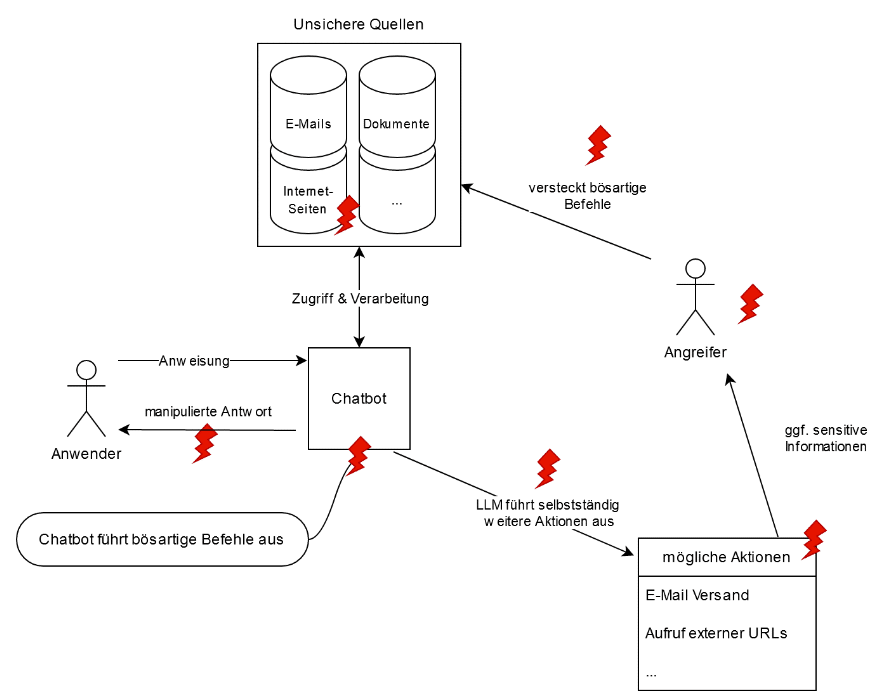

Indirect Prompt Injections entstehen, wenn Informationen aus unsicheren Quellen von LLMs verarbeitet werden. Angreifer können diese Situation ausnutzen, um die Daten zu manipulieren und unerwünschte Befehle in LLMs einzuschleusen und auszuführen. Sie können dadurch das Verhalten von LLMs gezielt beeinflussen und sie dazu bringen, schädliche Aktionen durchzuführen, ähnlich wie bei einem Social-Engineering-Angriff.

Ein manipulierter Chatbot könnte demnach glaubhaft argumentieren, warum eine schadhafte Aktion unbedingt genehmigt werden muss. Aktuell gibt es im IT-Sicherheitsbereich noch keine „Best-Practices“, um solche Angriffe zu verhindern. Das BSI betont, dass diese Art von Angriff aufgrund der intrinsischen Schwachstellen der derzeitigen Technologie grundsätzlich schwer zu verhindern ist.

Hier noch zwei hypothetische Beispiele für Indirect Prompt Injections bei KI-Sprachmodellen oder Chatbots liefern:

- Phishing-Versuch: Angenommen, ein Angreifer manipuliert den Input für einen Kundenservice-Chatbot von einer Bank. Der Angreifer könnte den Chatbot so manipulieren, dass er dem Benutzer glaubhaft argumentiert, dass es sicher ist, persönliche Informationen wie Kreditkartennummern oder Passwörter preiszugeben. Der Angreifer könnte dies tun, indem er den Chatbot mit einer überzeugenden Geschichte füttert, z.B. dass es ein Problem mit dem Konto des Benutzers gibt und dass dringend Aktionen erforderlich sind, um das Problem zu lösen.

- Verbreitung falscher Informationen: Ein Angreifer könnte einen Bildungschattbot so manipulieren, dass er falsche oder irreführende Informationen verbreitet. Beispielsweise könnte der Angreifer den Chatbot dazu bringen, zu behaupten, dass eine bestimmte Verschwörungstheorie wahr ist oder dass eine bestimmte medizinische Behandlung schädlich ist, obwohl dies nicht der Fall ist. Diese Art von Angriff könnte dazu verwendet werden, öffentliche Meinungen oder Verhaltensweisen auf schädliche Weise zu beeinflussen.

Das Problem der Daten- und Anweisungstrennung

Eine der Herausforderungen bei der Bekämpfung dieser Art von Angriffen ist, dass es bei LLMs keine klare Trennung zwischen Daten und Anweisungen gibt. In der menschlichen Kommunikation übermitteln Texte sowohl Informationen als auch Befehle, und dieses Konzept wird auch in die IT-Sphäre übertragen. Dies öffnet die Tür für potenzielle Missbrauchsszenarien.

Handlungsempfehlungen des BSI

Obwohl das BSI derzeit keine zuverlässige und nachhaltig sichere Mitigationsmaßnahme kennt, die die Funktionalität der LLMs nicht deutlich einschränkt, hat es einige Empfehlungen zur Verringerung der Risiken durch Indirect Prompt Injections abgegeben.

- Durchführung einer systematischen Risikoanalyse bei der Integration von LLMs in Apps.

- Ausschluss des Zugriffs auf unsichere Quellen.

- Implementierung von Maßnahmen, bei denen vor möglicherweise kritischen Aktionen ein Mensch eine Anfrage bestätigen muss.

- Einsatz einer Sandbox bei bestimmten Aktionen.

- Durchführung von Penetrationstests.

Versteckte und gefährliche Befehle

Die BSI-Warnung unterstreicht die Tatsache, dass es zahlreiche Möglichkeiten gibt, bei denen Benutzer nicht erkennen, dass es sich um potenziell schädliche Befehle handelt. Diese können verschlüsselt oder versteckt sein und werden vom Benutzer möglicherweise gar nicht bemerkt. Beispielsweise könnten Texte auf Websites in einer Schriftgröße null versteckt oder in einem Videotranskript eingebettet sein. Auch könnten sie in einer Form kodiert sein, die für den Menschen schwer lesbar ist.

Konkrete Angriffsszenarien

Bei der automatischen Textverarbeitung aus externen Quellen können Angreifer Ergebnisse gezielt manipulieren. Das BSI warnt vor verschiedenen Szenarien, unter anderem, dass der Chatbot rechtlich bedenkliche oder unerwünschte Aussagen trifft, Nutzer zum Aufrufen bösartiger Links motiviert, versucht, sensible Informationen zu erhalten oder weitere Plug-ins aufruft. Auf diese Weise könnten Angreifer potenziell Zugriff auf das E-Mail-Konto eines Benutzers oder mehr erhalten.

Schematischer Ablauf einer Indirect Prompt Injection mit möglichen Folgen am Beispiel eines Chatbots!

Fazit

Die Warnung des BSI vor den Risiken von Indirect Prompt Injections ist ein wichtiger Weckruf für alle, die mit großen KI-Sprachmodellen arbeiten oder diese nutzen. Die rasante Entwicklung dieser Technologie hat das Potenzial, die Art und Weise, wie wir kommunizieren und interagieren, zu revolutionieren, bringt aber auch neue Sicherheitsrisiken mit sich. Es ist daher von entscheidender Bedeutung, dass sowohl Entwickler als auch Nutzer sich dieser Risiken bewusst sind und angemessene Maßnahmen ergreifen, um sich dagegen zu schützen.

Die Warnungen des Bundesamtes für Sicherheit in der Informationstechnik (BSI) richten sich grundsätzlich an alle privaten und institutionellen Nutzer von KI-Sprachmodellen. In der Praxis betrifft dies in der Regel eher Unternehmen, Organisationen und Entwickler, die solche Modelle einsetzen, da diese die Kontrolle über die Implementierung und Nutzung haben.

Die Warnung kann jedoch auch für private Nutzer relevant sein, insbesondere wenn sie Dienste oder Anwendungen nutzen, die auf KI-Sprachmodellen basieren. Es ist wichtig, dass sie sich der potenziellen Risiken und Sicherheitsprobleme bewusst sind, um sicherzustellen, dass sie ein sicheres Online-Verhalten pflegen und gegebenenfalls zusätzliche Maßnahmen zum Schutz ihrer Daten und ihrer Privatsphäre ergreifen.

Zu beachten ist jedoch, dass die Hauptverantwortung für die Gewährleistung von Sicherheit und Datenschutz bei den Unternehmen und Entwicklern liegt, die diese Technologien einsetzen. Sie müssen die potenziellen Risiken verstehen und geeignete Maßnahmen ergreifen, um diese Risiken zu minimieren und zu kontrollieren.

Quelle: BSI

Lesen Sie auch: Malware-Warnung: Facebook wird von gefälschten ChatGPT- und Google Bard-Seiten überschwemmt

Hinweise: 1) Dieser Inhalt gibt den Stand der Dinge wieder, der zum Zeitpunkt der Veröffentlichung aktuell war. Die Wiedergabe einzelner Bilder, Screenshots, Einbettungen oder Videosequenzen dient zur Auseinandersetzung der Sache mit dem Thema.

2) Einzelne Beiträge entstanden durch den Einsatz von maschineller Hilfe und wurde vor der Publikation gewissenhaft von der Mimikama-Redaktion kontrolliert. (Begründung)